Por Yuval Abraham*

O exército israelense marcou dezenas de milhares de habitantes de Gaza como suspeitos de assassinato, usando um sistema de IA com pouca supervisão humana e uma política de baixas permissiva.

Em 2021, um livro intitulado The Human-Machine Team: How to Create Synergy Between Human and Artificial Intelligence That Will Revolutionize Our World (“A equipe homem-máquina: como criar sinergia entre inteligência humana e artificial que revolucionará nosso mundo”) foi lançado em inglês sob o pseudônimo de “Brigadeiro-general Y.S.” Nele, o autor – um homem que confirmamos ser o atual comandante da unidade de elite de inteligência israelense 8200 – defende o projeto de uma máquina especial que possa processar rapidamente grandes quantidades de dados para gerar milhares de “alvos” potenciais para os militares atacarem no calor de uma guerra. Essa tecnologia, escreve ele, resolveria o que descreveu como um “gargalo humano tanto para a localização dos novos alvos como para a tomada de decisões para aprová-los”.

Acontece que tal máquina realmente existe. Uma nova investigação da +972 Magazine e Local Call revela que o Exército israelense desenvolveu um programa baseado em inteligência artificial conhecido como “Lavender”, revelado aqui pela primeira vez. De acordo com seis oficiais de inteligência israelenses, que serviram no Exército durante a atual guerra na Faixa de Gaza e tiveram envolvimento direto com o uso de IA para gerar alvos para assassinato, a Lavender desempenhou um papel central no bombardeio sem precedentes de palestinos, especialmente durante os primeiros estágios da guerra. Na verdade, de acordo com as fontes, sua influência nas operações militares foi tal que eles trataram essencialmente os resultados da máquina de IA “como se fosse uma decisão humana”.

Formalmente, o sistema Lavender foi concebido para marcar todos os suspeitos de operar nas alas militares do Hamas e da Jihad Islâmica Palestina (PIJ), incluindo os de baixa patente, como potenciais alvos de bombardeio. As fontes disseram ao +972 e à Local Call que, durante as primeiras semanas da guerra, o Exército confiou quase completamente na Lavender, que registrou cerca de 37.000 palestinos como suspeitos de serem militantes – e suas casas – para possíveis ataques aéreos.

Durante os primeiros estágios da guerra, o Exército deu aprovação abrangente para que os oficiais adotassem as listas de mortes da Lavender, sem nenhuma exigência de verificar minuciosamente por que a máquina fez essas escolhas ou de examinar os dados brutos de inteligência em que se baseavam. Uma fonte afirmou que o pessoal humano muitas vezes servia apenas como um “carimbo de borracha” para as decisões da máquina, acrescentando que, normalmente, eles dedicariam pessoalmente apenas cerca de “20 segundos” a cada alvo antes de autorizar um bombardeio – apenas para garantir que o alvo marcado pela Lavender é masculino. Isto apesar de saber que o sistema comete o que é considerado “erro” em aproximadamente 10% dos casos, e é conhecido por marcar ocasionalmente indivíduos que têm apenas uma ligação frouxa com grupos militantes, ou nenhuma ligação.

Além disso, o Exército israelense atacou sistematicamente os indivíduos visados enquanto estes estavam em suas casas – geralmente à noite, enquanto todas as suas famílias estavam presentes – e não durante o decurso da atividade militar. Segundo as fontes, isso ocorreu porque, do ponto de vista considerado pela inteligência, era mais fácil localizar os indivíduos em suas residências particulares. Sistemas automatizados adicionais, incluindo um chamado “Where’s Daddy?” (“Onde está o papai?”) também revelados aqui pela primeira vez, foram usados especificamente para rastrear os indivíduos visados e realizar atentados quando eles entravam nas residências de suas famílias.

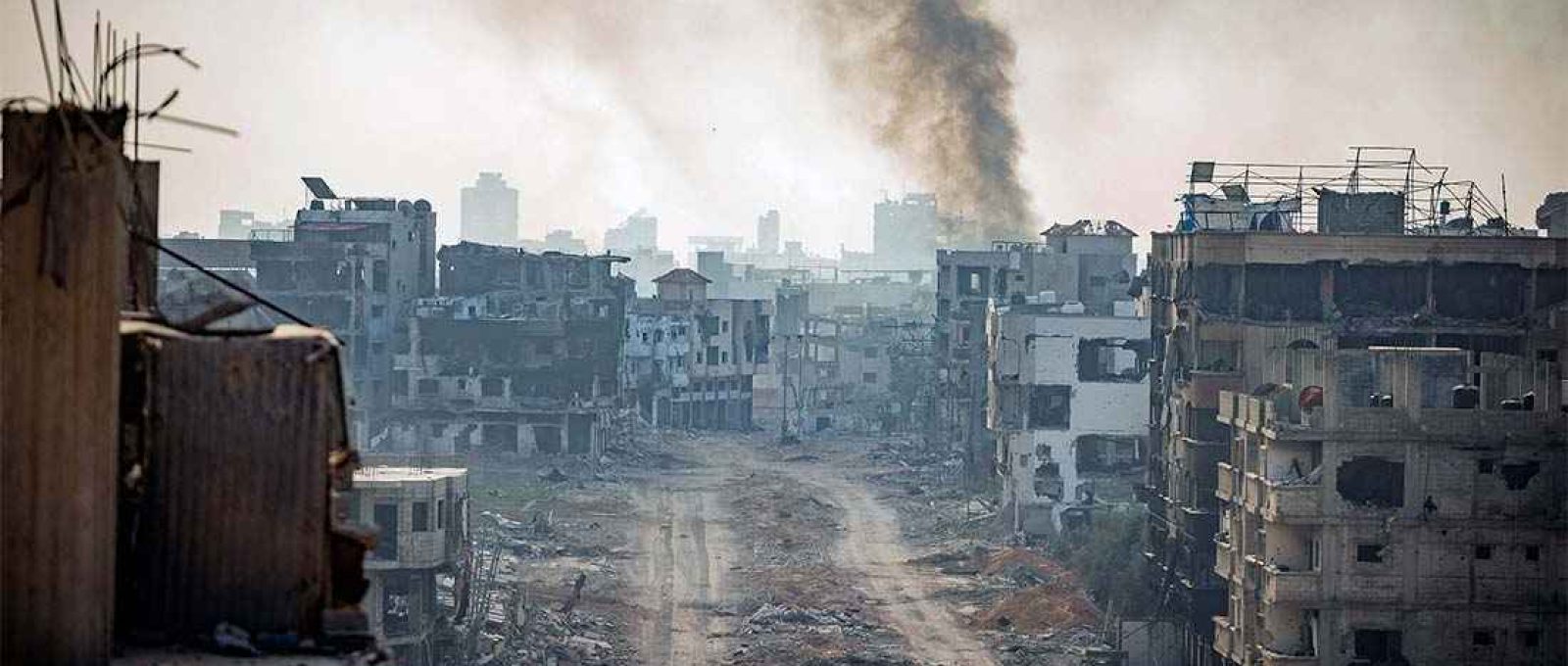

O resultado, como testemunharam as fontes, é que milhares de palestinos – a maioria deles mulheres e crianças ou pessoas que não estiveram envolvidas nos combates – foram exterminados por ataques aéreos israelenses, especialmente durante as primeiras semanas da guerra, por causa das decisões do programa de IA.

“Não estávamos interessados em matar agentes [do Hamas] apenas quando eles estavam em um edifício militar ou envolvidos em uma atividade militar”, disse A., um oficial de inteligência, ao +972 e Local Call. “Pelo contrário, as IDF bombardearam-nos em casa sem hesitação, como primeira opção. É muito mais fácil bombardear a casa de uma família. O sistema foi construído para procurá-los nessas situações.”

A máquina Lavender junta-se a outro sistema de IA, “The Gospel”, sobre o qual a informação foi revelada em uma investigação anterior pela +972 e Local Call em novembro de 2023, bem como nas próprias publicações dos militares israelenses. Uma diferença fundamental entre os dois sistemas está na definição do alvo: enquanto a The Gospel marca edifícios e estruturas a partir dos quais o Exército afirma que os militantes operam, a Lavender marca pessoas – e coloca-as em uma lista de morte.

Além disso, de acordo com as fontes, quando se tratou de atacar alegados militantes juniores marcados pela Lavender, o Exército preferiu usar apenas mísseis não guiados, vulgarmente conhecidos como bombas “burras” (em contraste com bombas de precisão “inteligentes”), que podem destruir edifícios inteiros em cima dos seus ocupantes e causam vítimas significativas. “Você não quer desperdiçar bombas caras com pessoas sem importância – é muito caro para o país e há uma escassez [dessas bombas]”, disse C., um dos oficiais de inteligência. Outra fonte disse que eles autorizaram pessoalmente o bombardeio de “centenas” de casas particulares de supostos agentes juniores marcados pela Lavender, com muitos desses ataques matando civis e famílias inteiras como “danos colaterais”.

Em uma medida sem precedentes, segundo duas das fontes, o Exército também decidiu durante as primeiras semanas da guerra que, para cada agente júnior do Hamas que a Lavender marcasse, era permitido matar até 15 ou 20 civis; no passado, os militares não autorizavam quaisquer “danos colaterais” durante assassinatos de militantes de baixa patente. As fontes acrescentaram que, no caso de o alvo ser um alto funcionário do Hamas com a patente de comandante de batalhão ou brigada, o Exército autorizou em diversas ocasiões o assassinato de mais de 100 civis no assassinato de um único comandante.

A investigação que se segue está organizada de acordo com as seis fases cronológicas da produção altamente automatizada de alvos do Exército israelense nas primeiras semanas da guerra em Gaza. Primeiro, explicamos a própria máquina Lavender, que marcou dezenas de milhares de palestinos usando IA. Em segundo lugar, revelamos o sistema “Where’s daddy?”, que rastreava esses alvos e sinalizava ao Exército quando eles entravam nas casas de suas famílias. Terceiro, descrevemos como as bombas “burras” foram escolhidas para atingir estas casas.

Quarto, explicamos como o Exército afrouxou o número permitido de civis que poderiam ser mortos durante o bombardeio de um alvo. Quinto, notamos como o software automatizado calculou de forma imprecisa a quantidade de não-combatentes em cada agregado familiar. E sexto, mostramos como em diversas ocasiões, quando uma casa era atingida, geralmente à noite, o alvo individual às vezes não estava lá dentro, porque os oficiais militares não verificaram a informação em tempo real.

Passo 1: gerar metas

“Depois que você automatiza, a geração de alvos enlouquece”

No Exército israelense, o termo “alvo humano” referia-se no passado a um agente militar superior que, de acordo com as regras do Departamento de Direito Internacional militar, pode ser morto em sua residência privada, mesmo que haja civis por perto. Fontes de inteligência disseram ao +972 e à Local Call que durante as guerras anteriores de Israel, uma vez que esta era uma forma “especialmente brutal” de matar alguém – muitas vezes matando uma família inteira ao lado do alvo – tais alvos humanos eram marcados com muito cuidado e apenas comandantes militares seniores foram bombardeados em suas casas, para manter o princípio da proporcionalidade ao abrigo do direito internacional.

Mas depois de 7 de outubro – quando militantes liderados pelo Hamas lançaram um ataque mortal às comunidades do sul de Israel, matando cerca de 1.200 pessoas e raptando 240 – o Exército, disseram as fontes, adotou uma abordagem dramaticamente diferente. No âmbito da “Operação Espadas de Ferro”, o Exército decidiu designar todos os agentes da ala militar do Hamas como alvos humanos, independentemente de sua posição ou importância militar. E isso mudou tudo.

A nova política também representou um problema técnico para a inteligência israelense. Em guerras anteriores, para autorizar o assassinato de um único alvo humano, um oficial tinha de passar por um processo complexo e demorado de “incriminação”: verificar provas de que a pessoa era de fato um membro sênior da ala militar do Hamas, procurar saber onde ele morava, suas informações de contato e, finalmente, saber quando ele estava em casa em tempo real. Quando a lista de alvos contava apenas com algumas dezenas de agentes de alto escalão, o pessoal de inteligência poderia cuidar individualmente do trabalho envolvido em incriminá-los e localizá-los.

No entanto, quando a lista foi alargada para incluir dezenas de milhares de agentes de escalão inferior, o Exército israelense percebeu que tinha que contar com software automatizado e inteligência artificial. O resultado, testemunham as fontes, foi que o papel do pessoal humano na incriminação dos palestinos como agentes militares foi deixado de lado, e a IA fez a maior parte do trabalho. De acordo com quatro das fontes que falaram com +972 e Local Call, a Lavender – que foi desenvolvida para criar alvos humanos na guerra atual – marcou cerca de 37.000 palestinos como suspeitos de serem “militantes do Hamas”, a maioria deles juniores, para assassinato (o porta-voz da IDF negou a existência de tal lista de mortes em uma declaração para a +972 e Local Call).

LIVRO RECOMENDADO

Israel x Palestina: 100 anos de guerra

• James L. Gelvin (Autor)

• Em português

• Capa comum

“Não sabíamos quem eram os agentes juniores, porque Israel não os rastreava rotineiramente [antes da guerra]”, explicou o oficial superior B. ao +972 e à Local Call, esclarecendo a razão por trás do desenvolvimento desta máquina de alvos específica para a guerra atual. “Eles queriam nos permitir atacar [os agentes juniores] automaticamente. Esse é o Santo Graal. Depois que você se automatiza, a geração de alvos enlouquece.”

As fontes disseram que a aprovação para adotar automaticamente as listas de mortes da Lavender, que anteriormente eram usadas apenas como ferramenta auxiliar, foi concedida cerca de duas semanas após o início da guerra, depois que o pessoal da inteligência verificou “manualmente” a precisão de uma amostra aleatória de várias centenas de alvos selecionados pelo sistema de IA. Quando essa amostra concluiu que os resultados da Lavender atingiram 90% de precisão na identificação da afiliação de um indivíduo ao Hamas, o Exército autorizou a utilização abrangente do sistema. A partir desse momento, as fontes disseram que se a Lavender decidisse que um indivíduo era um militante do Hamas, eles seriam essencialmente solicitados a tratar isso como uma ordem, sem a necessidade de verificar de forma independente porque a máquina fez essa escolha ou de examinar os dados brutos de inteligência sobre os quais ela se baseia.

“Às cinco da manhã, [a Força Aérea] vinha e bombardeava todas as casas que havíamos marcado”, disse B. “Tiramos milhares de pessoas. Não analisamos um por um – colocamos tudo em sistemas automatizados e, assim que um dos [indivíduos marcados] chegava em casa, ele imediatamente se tornava um alvo. Nós o bombardeamos e à sua casa.”

“Foi muito surpreendente para mim que nos pediram para bombardear uma casa para matar um soldado, cuja importância nos combates era tão baixa”, disse uma fonte sobre o uso de IA para marcar alegados militantes de baixa patente. “Apelidei esses alvos de ‘alvos de lixo’. Mesmo assim, considerei-os mais éticos do que os alvos que bombardeamos apenas para ‘dissuasão’ – edifícios altos que são evacuados e derrubados apenas para causar destruição.”

Os resultados mortais deste afrouxamento das restrições na fase inicial da guerra foram surpreendentes. De acordo com dados do Ministério da Saúde palestino em Gaza, dos quais o Exército israelense depende quase exclusivamente desde o início da guerra, Israel matou cerca de 15 mil palestinos – quase metade do número de mortos até agora – nas primeiras seis semanas da guerra, até que um cessar-fogo de uma semana foi acordado em 24 de novembro.

“Quanto mais informação e variedade, melhor”

O software Lavender analisa informações recolhidas sobre a maioria dos 2,3 milhões de residentes da Faixa de Gaza através de um sistema de vigilância em massa, depois avalia e classifica a probabilidade de cada pessoa em particular estar ativa na ala militar do Hamas ou na PIJ. Segundo fontes, a máquina dá a quase todas as pessoas em Gaza uma classificação de 1 a 100, expressando a probabilidade de serem militantes.

A Lavender aprende a identificar características de agentes conhecidos do Hamas e da PIJ, cujas informações foram alimentadas na máquina como dados de treinamento, e depois a localizar essas mesmas características – também chamadas de “atributos” – entre a população em geral, explicaram as fontes. Um indivíduo que apresente diversas características incriminatórias diferentes alcançará uma classificação elevada e, portanto, automaticamente se tornará um alvo potencial para assassinato.

Em The Human-Machine Team, o livro mencionado no início deste artigo, o atual comandante da Unidade 8200 defende tal sistema sem se referir à Lavender pelo nome (o próprio comandante também não é identificado, mas cinco fontes na 8200 confirmaram que o comandante é o autor, conforme relatado também pelo Haaretz). Descrevendo o pessoal humano como um “gargalo” que limita a capacidade do Exército durante uma operação militar, o comandante lamenta: “Nós [humanos] não conseguimos processar tanta informação. Não importa quantas pessoas você tenha encarregado de produzir alvos durante a guerra – você ainda não consegue produzir alvos suficientes por dia.”

A solução para este problema, diz ele, é a inteligência artificial. O livro oferece um breve guia para construir uma “máquina alvo”, semelhante em descrição à Lavender, baseada em IA e algoritmos de aprendizado de máquina. Incluídos neste guia estão vários exemplos das “centenas e milhares” de recursos que podem aumentar a classificação de um indivíduo, como estar em um grupo de WhatsApp com um militante conhecido, trocar de celular a cada poucos meses e mudar de endereço com frequência.

“Quanto mais informação e mais variedade, melhor”, escreve o comandante. “Informações visuais, informações de celular, conexões de redes sociais, informações do campo de batalha, contatos telefônicos, fotos.” Embora os humanos selecionem esses recursos inicialmente, continua o comandante, com o tempo a máquina identificará os recursos por conta própria. Isto, diz ele, pode permitir que os militares criem “dezenas de milhares de alvos”, enquanto a decisão real sobre atacá-los ou não continuará a ser uma decisão humana.

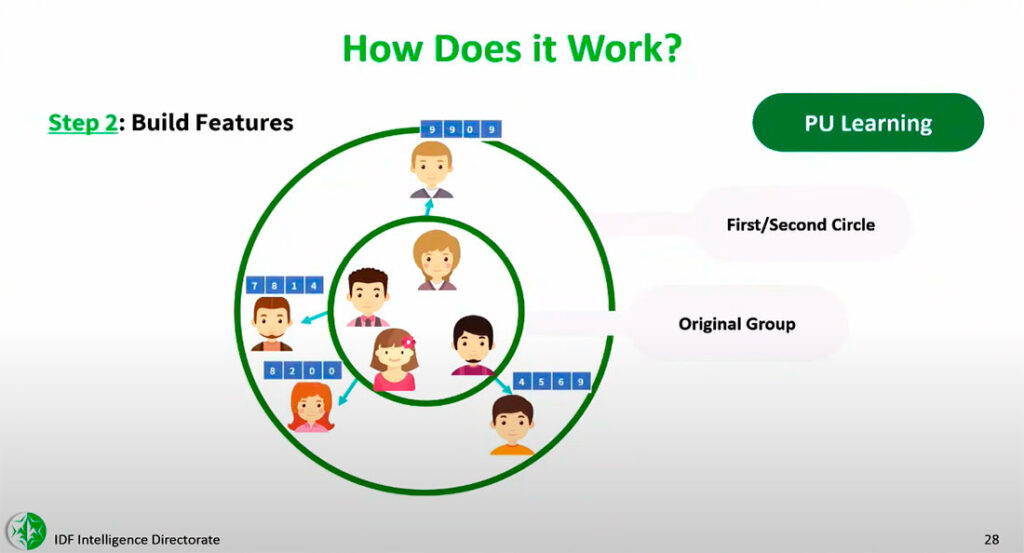

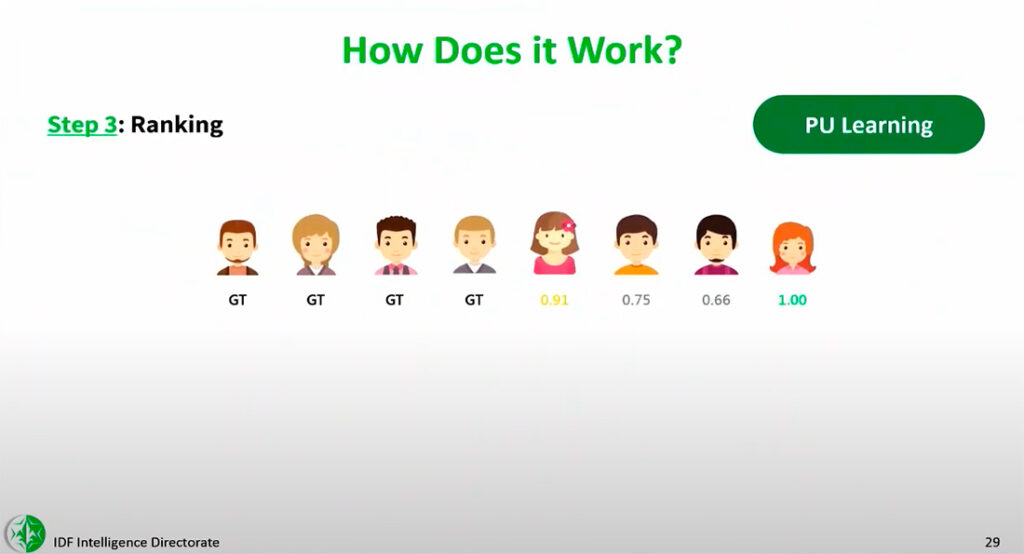

O livro não é a única vez que um alto comandante israelense insinuou a existência de máquinas-alvo humanas como a Lavender. O +972 e Local Call obtiveram imagens de uma palestra privada proferida pelo comandante do centro secreto de Ciência de Dados e IA da Unidade 8200, “coronel Yoav”, na semana de IA da Universidade de Tel Aviv em 2023, que foi noticiada na época pela mídia israelense.

Na palestra, o comandante fala sobre uma nova e sofisticada máquina de alvos usada pelo Exército israelense que detecta “pessoas perigosas” com base em sua semelhança com listas existentes de militantes conhecidos nos quais foi treinada. “Usando o sistema, conseguimos identificar os comandantes do esquadrão de mísseis do Hamas”, disse o “coronel Yoav” na palestra, referindo-se à operação militar de Israel de maio de 2021 em Gaza, quando a máquina foi usada pela primeira vez.

Os slides da apresentação da palestra, também obtidos pela +972 e Local Call, contêm ilustrações de como a máquina funciona: ela recebe dados sobre os agentes existentes do Hamas, aprende a perceber suas características e depois avalia outros palestinos com base em sua semelhança com os militantes.

“Classificamos os resultados e determinamos o limite [no qual atacar um alvo]”, disse o “coronel Yoav” na palestra, enfatizando que “eventualmente, pessoas de carne e osso tomam as decisões. Na área da defesa, eticamente falando, colocamos muita ênfase nisso. Essas ferramentas se destinam a ajudar [oficiais de inteligência] a quebrar suas barreiras.”

Na prática, porém, fontes que usaram a Lavender nos últimos meses dizem que a agência e a precisão humanas foram substituídas pela criação de alvos em massa e pela letalidade.

“Não havia política de ‘erro zero’”

B., um oficial superior que usou a Lavender, repetiu para a +972 e Local Call que na guerra atual, os oficiais não eram obrigados a revisar de forma independente as avaliações do sistema de IA, a fim de economizar tempo e permitir a produção em massa de alvos humanos sem obstáculos.

“Tudo era estatístico, tudo estava arrumado – era muito seco”, disse B. Ele observou que esta falta de supervisão foi permitida apesar das verificações internas mostrarem que os cálculos da Lavender foram considerados precisos apenas 90% das vezes; em outras palavras, sabia-se antecipadamente que 10% dos alvos humanos programados para assassinato não eram de todo membros da ala militar do Hamas.

Por exemplo, fontes explicaram que a máquina Lavender às vezes sinalizava erroneamente indivíduos que tinham padrões de comunicação semelhantes aos de agentes conhecidos do Hamas ou da PIJ – incluindo funcionários da polícia e da defesa civil, parentes de militantes, residentes que por acaso tinham nome e apelido idênticos aos de um operacional e moradores de Gaza que usaram um dispositivo que pertenceu a um agente do Hamas.

“Quão próxima uma pessoa deve estar do Hamas para ser [considerada por uma máquina de IA] afiliada à organização?” disse uma fonte que criticou a imprecisão da Lavender. “É um limite vago. Uma pessoa que não recebe salário do Hamas, mas o ajuda em todo tipo de coisas, é um agente do Hamas? Alguém que esteve no Hamas no passado, mas já não está lá hoje, é um agente do Hamas? Cada um desses recursos – características que uma máquina sinalizaria como suspeitas – é impreciso.”

Existem problemas semelhantes com a capacidade das máquinas de alvo de avaliarem o telefone usado por um indivíduo marcado para assassinato. “Na guerra, os palestinos trocam de telefone o tempo todo”, disse a fonte. “As pessoas perdem contato com suas famílias, dão o telefone para um amigo ou esposa, talvez o percam. Não há como confiar 100% no mecanismo automático que determina qual número [de telefone] pertence a quem.”

Segundo as fontes, o Exército sabia que a supervisão humana mínima não iria descobrir essas falhas. “Não havia uma política de ‘erro zero’. Os erros foram tratados estatisticamente”, disse uma fonte que usou a Lavender. “Devido ao escopo e à magnitude, o protocolo era que mesmo que você não tivesse certeza de que a máquina estava certa, você sabia que estatisticamente estava tudo bem. Então você vai em frente.”

“Isso já foi comprovado”, disse B., a fonte sênior. “Há algo na abordagem estatística que estabelece uma certa norma e padrão. Houve uma quantidade ilógica de [bombardeios] nesta operação. Isso é incomparável, na minha memória. E confio muito mais em um mecanismo estatístico do que em um soldado que perdeu um amigo há dois dias. Todos lá, inclusive eu, perderam pessoas no dia 7 de outubro. A máquina fez isso com frieza. E isso tornou tudo mais fácil.”

Outra fonte de inteligência, que defendeu a confiança nas listas de assassinatos de suspeitos palestinos geradas pela Lavender, argumentou que valia a pena investir o tempo de um oficial de inteligência apenas para verificar a informação se o alvo fosse um comandante sênior do Hamas. “Mas quando se trata de um militante júnior, você não quer investir mão-de-obra e tempo nisso”, disse ele. “Na guerra, não há tempo para incriminar todos os alvos. Portanto, você está disposto a assumir a margem de erro de usar inteligência artificial, arriscando danos colaterais e a morte de civis, e arriscando atacar por engano, e conviver com isso.”

B. disse que a razão para esta automação foi um esforço constante para gerar mais alvos para assassinato. “Em um dia sem alvos [cuja classificação de recurso era suficiente para autorizar um ataque], atacamos com um limite inferior. Éramos constantemente pressionados: ‘Tragam-nos mais alvos.’ Eles gritavam mesmo conosco. Terminamos [de matar] nossos alvos muito rapidamente.”

Ele explicou que ao diminuir o limite de classificação da Lavender, isso marcaria mais pessoas como alvos de ataques. “No seu auge, o sistema conseguiu gerar 37.000 pessoas como potenciais alvos humanos”, disse B. “Mas os números mudavam constantemente, porque depende de onde se define o padrão do que é um agente do Hamas. Houve momentos em que um agente do Hamas era definido de forma mais ampla, e depois a máquina começou a nos trazer todo o tipo de pessoal da defesa civil, agentes da polícia, sobre os quais seria uma pena desperdiçar bombas. Eles ajudam o governo do Hamas, mas na verdade não colocam os soldados em perigo.”

Uma fonte que trabalhou com a equipe militar de ciência de dados que treinou a Lavender disse que os dados coletados de funcionários do Ministério de Segurança Interna administrado pelo Hamas, que ele não considera militantes, também foram inseridos na máquina. “Fiquei incomodado com o fato de que, quando a Lavender foi treinada, eles usaram o termo ‘agente do Hamas’ vagamente e incluíram pessoas que eram trabalhadores da defesa civil no conjunto de dados de treinamento”, disse ele.

A fonte acrescentou que mesmo que se acredite que estas pessoas merecem ser mortas, treinar o sistema com base em seus perfis de comunicação tornou a Lavender mais propensa a selecionar civis por engano quando seus algoritmos foram aplicados à população em geral. “Como é um sistema automático que não é operado manualmente por humanos, o significado desta decisão é dramático: significa que você está incluindo muitas pessoas com perfil de comunicação civil como alvos potenciais.”

“Só verificamos se o alvo era um homem”

Os militares israelenses rejeitam categoricamente estas alegações. Em uma declaração ao +972 e à Local Call, o porta-voz das FDI negou o uso de inteligência artificial para incriminar alvos, dizendo que estas são apenas “ferramentas auxiliares que auxiliam os oficiais no processo de incriminação”. A declaração prosseguia: “Em qualquer caso, é necessário um exame independente por um analista [de inteligência], que verifique se os alvos identificados são alvos legítimos para ataque, de acordo com as condições estabelecidas nas diretrizes das FDI e no direito internacional”.

No entanto, fontes disseram que o único protocolo de supervisão humana em vigor antes de bombardear as casas de supostos militantes “juniores” marcados pela Lavender era realizar uma única verificação: garantir que o alvo selecionado pela IA fosse um homem e não uma mulher. A suposição no Exército era que se o alvo fosse uma mulher, a máquina provavelmente teria cometido um erro, porque não há mulheres nas fileiras das alas militares do Hamas e do PIJ.

“Um ser humano tinha que [verificar o alvo] por apenas alguns segundos”, disse B., explicando que este se tornou o protocolo depois de perceber que o sistema Lavender estava “acertando” na maioria das vezes. “No início, fizemos verificações para garantir que a máquina não ficasse confusa. Mas em algum momento confiamos no sistema automático e apenas verificamos se [o alvo] era um homem – isso era o suficiente. Não demora muito para saber se alguém tem voz masculina ou feminina.”

Para realizar a verificação homem/mulher, B. afirmou que na guerra atual, “eu investiria 20 segundos para cada alvo nesta fase, e faria dezenas deles todos os dias. Eu não tinha nenhum valor agregado como ser humano, além de ser um selo de aprovação. Isso economizou muito tempo. Se [o agente] aparecesse no mecanismo automatizado e eu verificasse que era um homem, haveria permissão para bombardeá-lo, sujeito a um exame de danos colaterais.”

Na prática, fontes disseram que isto significava que para os homens civis marcados como erro pela Lavender, não havia nenhum mecanismo de supervisão para detectar o erro. De acordo com B., um erro comum ocorria “se o alvo [do Hamas] desse [seu telefone] ao filho, ao irmão mais velho ou apenas a um homem aleatório. Essa pessoa será bombardeada em sua casa com sua família. Isso aconteceu com frequência. Esses foram a maioria dos erros causados pela Lavender”, disse B.

Passo 2: ligar alvos a casas de família

“A maioria das pessoas que você matou eram mulheres e crianças”

A próxima etapa do procedimento de assassinato do Exército israelense é identificar onde atacar os alvos gerados pela Lavender.

Em uma declaração para a +972 e Local Call, o porta-voz das FDI afirmou em resposta a este artigo que “o Hamas coloca seus agentes e meios militares no coração da população civil, usa sistematicamente a população civil como escudos humanos e conduz combates a partir de dentro estruturas civis, incluindo locais sensíveis como hospitais, mesquitas, escolas e instalações da ONU. As FDI estão vinculadas e agem de acordo com o direito internacional, dirigindo seus ataques apenas contra alvos militares e agentes militares.”

As seis fontes com quem falamos repetiram isso até certo ponto, dizendo que o extenso sistema de túneis do Hamas passa deliberadamente por baixo de hospitais e escolas; que os militantes do Hamas usam ambulâncias para se locomoverem; e que inúmeros meios militares foram situados perto de edifícios civis. As fontes argumentaram que muitos ataques israelenses matam civis como resultado destas táticas do Hamas – uma caracterização que os grupos de direitos humanos alertam que evita o ônus de Israel por infligir baixas as vítimas.

Contudo, em contraste com as declarações oficiais do Exército israelense, as fontes explicaram que uma das principais razões para o número de mortos sem precedentes resultante do atual bombardeio de Israel é o fato de o Exército ter atacado sistematicamente alvos em suas residências privadas, juntamente com suas famílias – em parte porque era mais fácil, do ponto de vista da inteligência, marcar casas familiares usando sistemas automatizados.

Na verdade, várias fontes sublinharam que, ao contrário de numerosos casos de agentes do Hamas envolvidos em atividades militares a partir de áreas civis, no caso de ataques sistemáticos de assassinato, o Exército fez rotineiramente a escolha ativa de bombardear supostos militantes quando dentro de lares civis de onde não ocorreu nenhuma atividade militar. Esta escolha, disseram eles, foi um reflexo da forma como o sistema de vigilância em massa de Israel em Gaza foi concebido.

As fontes disseram ao +972 e à Local Call que, uma vez que todos em Gaza tinham uma casa privada à qual podiam estar associados, os sistemas de vigilância do Exército podiam “ligar” fácil e automaticamente os indivíduos às casas das famílias. Para identificar em tempo real o momento em que os agentes entram em suas casas, foram desenvolvidos vários softwares automáticos adicionais. Esses programas rastreiam milhares de indivíduos simultaneamente, identificam quando estão em casa e enviam um alerta automático ao oficial de seleção, que então marca a casa para bombardeio. Um dos vários softwares de rastreamento, revelados aqui pela primeira vez, chama-se “Where’s daddy?”

“Você coloca centenas [de alvos] no sistema e espera para ver quem você pode matar”, disse uma fonte com conhecimento do sistema. “Chama-se caça ampla: você copia e cola das listas que o sistema de destino produz.”

A evidência desta política também fica clara nos dados: durante o primeiro mês da guerra, mais de metade das vítimas mortais – 6.120 pessoas – pertenciam a 1.340 famílias, muitas das quais foram completamente exterminadas enquanto estavam dentro de suas casas, segundo dados da ONU. A proporção de famílias inteiras bombardeadas em suas casas na guerra atual é muito maior do que na operação israelense em Gaza de 2014 (que foi até então a guerra mais mortal de Israel na Faixa), sugerindo ainda mais a proeminência desta política.

Outra fonte disse que cada vez que o ritmo de assassinatos diminuía, mais alvos eram adicionados a sistemas como “Where’s daddy?” para localizar indivíduos que entraram em suas casas e poderiam, portanto, ser bombardeados. Ele disse que a decisão sobre quem colocar nos sistemas de rastreamento poderia ser tomada por oficiais de patente relativamente baixa na hierarquia militar.

“Um dia, totalmente por minha própria vontade, adicionei cerca de 1.200 novos alvos ao sistema [de rastreamento], porque o número de ataques [que estávamos conduzindo] diminuiu”, disse a fonte. “Isso fez sentido para mim. Em retrospecto, parece que tomei uma decisão séria. E tais decisões não foram tomadas em altos níveis.”

LIVRO RECOMENDADO:

A próxima onda: Inteligência artificial, poder e o maior dilema do século XXI

• Mustafa Suleyman e Michael Bhaskar (Autores)

• Em português

• Capa comum ou eBook Kindle

As fontes disseram que nas primeiras duas semanas da guerra, “vários milhares” de alvos foram inicialmente incluídos em programas de localização como Where’s daddy?. Estes incluíam todos os membros da unidade de elite das forças especiais do Hamas, Nukhba, todos os agentes antitanques do Hamas e qualquer pessoa que entrasse em Israel em 7 de outubro.

“No final foram todos [marcados pela Lavender]”, explicou uma fonte. “Dezenas de milhares. Isto aconteceu algumas semanas depois, quando as brigadas [israelenses] entraram em Gaza, e já havia menos pessoas não envolvidas [ou seja, civis] nas áreas do norte.” Segundo esta fonte, até alguns menores foram marcados pela Lavender como alvos para bombardeio. “Normalmente, os agentes têm mais de 17 anos, mas isso não era uma condição.”

A Lavender e sistemas como Where’s daddy? foram assim combinados com efeitos mortais, matando famílias inteiras, disseram fontes. Adicionando um nome das listas geradas pela Lavender ao Where’s daddy?, sistema de rastreamento residencial, explicou A., a pessoa marcada seria colocada sob vigilância contínua e poderia ser atacada assim que colocasse os pés em sua casa, desabando a casa sobre todos que estivessem lá dentro.

“Digamos que você calcule [que há um] [agente] do Hamas mais 10 [civis na casa]”, disse A. “Normalmente, esses 10 serão mulheres e crianças. É tão absurdo que a maioria das pessoas que você matou eram mulheres e crianças.”

Passo 3: escolher uma arma

“Normalmente realizamos os ataques com ‘bombas burras’”

Depois que a Lavender marcou um alvo para assassinato, o pessoal do Exército verificou que eles são do sexo masculino e o software de rastreamento localizou o alvo em sua casa, o próximo estágio é escolher a munição com a qual bombardeá-los.

Em dezembro de 2023, a CNN informou que, de acordo com estimativas da inteligência dos EUA, cerca de 45% das munições utilizadas pela Força Aérea israelense em Gaza eram bombas “burras”, que são conhecidas por causarem mais danos colaterais do que bombas guiadas. Em resposta à reportagem da CNN, um porta-voz do Exército citado no artigo disse: “Como militares comprometidos com o direito internacional e com um código de conduta moral, estamos dedicando vastos recursos para minimizar os danos aos civis que o Hamas forçou a desempenhar o papel de escudos humanos. A nossa guerra é contra o Hamas, não contra o povo de Gaza.”

Três fontes de inteligência, no entanto, disseram ao +972 e ao Local Call que os agentes juniores marcados pela Lavender foram assassinados apenas com bombas burras, no interesse de salvar armamentos mais caros. A implicação, explicou uma fonte, era que o Exército não atacaria um alvo júnior se ele morasse em um prédio alto, porque o exército não queria gastar uma “bomba de solo” mais precisa e cara (com efeito colateral mais limitado ) para matá-lo. Mas se um alvo júnior morasse em um prédio com apenas alguns andares, o Exército estava autorizado a matá-lo e a todos no prédio com uma bomba burra.

“Foi assim com todos os alvos juniores”, testemunhou C., que utilizou vários programas automatizados na guerra atual. “A única questão era: é possível atacar o edifício em termos de danos colaterais? Porque normalmente fazíamos os ataques com bombas burras, e isso significava literalmente destruir a casa inteira em cima dos seus ocupantes. Mas mesmo que um ataque seja evitado, você não se importa – você passa imediatamente para o próximo alvo. Por causa do sistema, as metas nunca terminam. Você tem outros 36.000 esperando.”

Passo 4: autorizar vítimas civis

“Atacamos quase sem considerar os danos colaterais”

Uma fonte disse que ao atacar agentes juniores, incluindo aqueles marcados por sistemas de IA como a Lavender, o número de civis que eles foram autorizados a matar ao lado de cada alvo foi fixado em até 20 durante as primeiras semanas da guerra. Outra fonte afirmou que o número fixo era de até 15. Esses “graus de danos colaterais”, como os militares os chamam, foram aplicados amplamente a todos os suspeitos de serem militantes juniores, disseram as fontes, independentemente de sua posição, importância militar e idade, e sem exame específico caso-a-caso para pesar a vantagem militar de assassiná-los contra os danos esperados aos civis.

De acordo com A., que foi oficial em uma sala de operações alvo na guerra atual, o departamento de direito internacional do Exército nunca antes deu uma “aprovação tão ampla” para um grau tão elevado de danos colaterais. “Não se trata apenas de poder matar qualquer pessoa que seja soldado do Hamas, o que é claramente permitido e legítimo em termos do direito internacional”, disse A. “Mas eles dizem diretamente: ‘Você tem permissão para matá-los junto com muitos civis’.

“Cada pessoa que vestisse um uniforme do Hamas nos últimos um ou dois anos poderia ser bombardeada com 20 [civis mortos como] danos colaterais, mesmo sem permissão especial”, continuou A. “Na prática, o princípio da proporcionalidade não existia.”

Segundo A., essa foi a política durante a maior parte do tempo em que ele serviu. Só mais tarde os militares baixaram o grau de danos colaterais. “Neste cálculo, também poderiam ser 20 crianças para um agente júnior… realmente não era assim no passado”, explicou A. Questionado sobre a lógica de segurança por trás desta política, A. respondeu: “Letalidade”.

O grau de dano colateral predeterminado e fixo ajudou a acelerar a criação em massa de alvos usando a máquina Lavender, disseram as fontes, porque economizou tempo. B. afirmou que o número de civis que foram autorizados a matar na primeira semana da guerra por cada suposto militante júnior marcado pela IA era 15, mas que este número “aumentou e diminuiu” ao longo do tempo.

“No início, atacamos quase sem considerar os danos colaterais”, disse B. sobre a primeira semana após 7 de outubro. “Na prática, você realmente não contava as pessoas [em cada casa bombardeada], porque não era possível dizer se eles estão em casa ou não. Depois de uma semana, começaram as restrições aos danos colaterais. O número caiu [de 15] para cinco, o que dificultou muito o ataque, porque se toda a família estivesse em casa não poderíamos bombardear. Então eles aumentaram o número novamente.”

“Sabíamos que mataríamos mais de 100 civis”

Fontes disseram ao +972 e à Local Call que agora, em parte devido à pressão americana, o Exército israelense não está mais gerando em massa alvos humanos juniores para bombardear casas de civis. O fato de a maioria das casas na Faixa de Gaza já terem sido destruídas ou danificadas, e de quase toda a população ter sido deslocada, também prejudicou a capacidade do Exército de confiar em bases de dados de inteligência e em programas automatizados de localização de casas.

E. afirmou que o bombardeio maciço de militantes juniores ocorreu apenas na primeira ou segunda semana da guerra e depois foi interrompido principalmente para não desperdiçar bombas. “Existe uma economia de munições”, disse E. “Eles sempre tiveram medo de que houvesse [uma guerra] na arena norte [com o Hezbollah no Líbano]. Eles não atacam mais esse tipo de gente [júnior].”

No entanto, os ataques aéreos contra altos comandantes do Hamas ainda estão em curso, e fontes disseram que, para estes ataques, os militares estão autorizando a morte de “centenas” de civis por alvo – uma política oficial para a qual não há precedente histórico em Israel, ou mesmo nas recentes operações militares dos EUA.

“No bombardeio do comandante do Batalhão Shuja’iya, sabíamos que mataríamos mais de 100 civis”, B. lembrou de um atentado de 2 de dezembro que o porta-voz das FDI disse ter como objetivo assassinar Wisam Farhat. “Para mim, psicologicamente, foi incomum. Mais de 100 civis – isso ultrapassa alguma linha vermelha.” Amjad Al-Sheikh, um jovem palestino de Gaza, disse que muitos de seus familiares foram mortos naquele atentado. Morador de Shuja’iya, a leste da cidade de Gaza, ele estava em um supermercado local naquele dia quando ouviu cinco explosões que partiram as janelas de vidro.

“Corri para a casa da minha família, mas não havia mais prédios lá”, disse Al-Sheikh ao +972 e Local Call. “A rua estava cheia de gritos e fumaça. Blocos residenciais inteiros transformaram-se em montanhas de escombros e poços profundos. As pessoas começaram a procurar no cimento, com as mãos, e eu também, em busca de sinais da casa da minha família.”

A esposa e a filha de Al-Sheikh sobreviveram – protegidas dos escombros por um armário que caiu em cima delas – mas ele encontrou outros 11 membros de sua família, entre eles as suas irmãs, irmãos e seus filhos pequenos, mortos sob os escombros. De acordo com o grupo de direitos humanos B’Tselem, o bombardeio desse dia destruiu dezenas de edifícios, matou dezenas de pessoas e enterrou centenas sob as ruínas das suas casas.

“Famílias inteiras foram mortas”

Fontes de inteligência disseram ao +972 e à Local Call que participaram de ataques ainda mais mortíferos. Para assassinar Ayman Nofal, comandante da Brigada Central de Gaza do Hamas, uma fonte disse que o Exército autorizou o assassinato de aproximadamente 300 civis, destruindo vários edifícios em ataques aéreos no campo de refugiados de Al-Bureij em 17 de outubro, com base em uma localização imprecisa de Nofal. Imagens de satélite e vídeos do local mostram a destruição de vários grandes edifícios de apartamentos de vários andares.

“Entre 16 e 18 casas foram destruídas no ataque”, disse Amro Al-Khatib, um residente do campo, ao +972 e Local Call. “Não conseguíamos distinguir um apartamento do outro – todos se misturaram nos escombros e encontramos partes de corpos humanos por toda parte.”

Na sequência, Al-Khatib relembrou cerca de 50 cadáveres sendo retirados dos escombros e cerca de 200 pessoas feridas, muitas delas gravemente. Mas esse foi apenas o primeiro dia. Os residentes do campo passaram cinco dias retirando os mortos e feridos, disse ele.

Nael Al-Bahisi, um paramédico, foi um dos primeiros a chegar ao local. Ele contou entre 50-70 vítimas naquele primeiro dia. “Em determinado momento, entendemos que o alvo do ataque era o comandante do Hamas, Ayman Nofal”, disse ele à +972 e Local Call. “Eles o mataram e também muitas pessoas que não sabiam que ele estava lá. Famílias inteiras com crianças foram mortas.”

Outra fonte de inteligência disse à +972 e à Local Call que o Exército destruiu um arranha-céu em Rafah em meados de dezembro, matando “dezenas de civis”, para tentar matar Mohammed Shabaneh, o comandante da Brigada Rafah do Hamas (que não está claro se ele foi ou não morto no ataque). Muitas vezes, disse a fonte, os comandantes superiores escondem-se em túneis que passam por baixo de edifícios civis e, portanto, a escolha de assassiná-los com um ataque aéreo mata necessariamente civis.

“A maioria dos feridos eram crianças”, disse Wael Al-Sir, 55 anos, que testemunhou o ataque em grande escala que alguns habitantes de Gaza acreditam ter sido uma tentativa de assassinato. Ele disse à +972 e à Local Call que o atentado de 20 de dezembro destruiu um “bloco residencial inteiro” e matou pelo menos 10 crianças.

“Havia uma política completamente permissiva em relação às baixas das operações [de bombardeio] – tão permissiva que, na minha opinião, tinha um elemento de vingança”, afirmou D., uma fonte de inteligência. “O cerne disto foram os assassinatos de altos comandantes [do Hamas e do PIJ], pelos quais estavam dispostos a matar centenas de civis. Fizemos um cálculo: quantos para um comandante de brigada, quantos para um comandante de batalhão e assim por diante.”

“Havia regulamentações, mas elas eram muito brandas”, disse E., outra fonte de inteligência. “Matamos pessoas com danos colaterais na casa dos dois dígitos, se não na casa dos três dígitos. São coisas que nunca aconteceram antes.”

Uma taxa tão elevada de “danos colaterais” é excepcional não só em comparação com o que o Exército israelense anteriormente considerava aceitável, mas também em comparação com as guerras travadas pelos Estados Unidos no Iraque, na Síria e no Afeganistão.

O general Peter Gersten, vice-comandante de Operações e Inteligência na operação de combate ao ISIS no Iraque e na Síria, disse a uma revista de defesa dos EUA em 2021 que um ataque com danos colaterais de 15 civis desviou-se do procedimento; para realizá-lo, ele teve que obter permissão especial do chefe do Comando Central dos EUA, general Lloyd Austin, hoje Secretário de Defesa.

“Com Osama Bin Laden, você teria um NCV [Non-combatant Casualty Value] de 30, mas se você tivesse um comandante de baixo escalão, seu NCV era normalmente zero”, disse Gersten. “Nós rodamos zero por muito tempo.”

“Disseram-nos: ‘O que você puder, bombardeie’”

Todas as fontes entrevistadas para esta investigação disseram que os massacres do Hamas em 7 de outubro e o sequestro de reféns influenciaram grandemente a política de fogo do Exército e os graus de danos colaterais. “No início, a atmosfera era dolorosa e vingativa”, disse B., que foi convocado para o Exército imediatamente após 7 de outubro e serviu em uma sala de operações alvo. “As regras eram muito brandas. Eles derrubaram quatro prédios quando souberam que o alvo estava em um deles. Foi louco.”

“Havia uma dissonância: por um lado, as pessoas aqui estavam frustradas porque não estávamos atacando o suficiente”, continuou B.. “Por outro lado, no final das contas, vemos que mais mil habitantes de Gaza morreram, a maioria deles civis.”

“Havia histeria nas fileiras profissionais”, disse D., que também foi convocado imediatamente após 7 de outubro. “Eles não tinham a menor ideia de como reagir. A única coisa que sabiam fazer era começar a bombardear como loucos para tentar desmantelar as capacidades do Hamas.”

D. sublinhou que não lhes foi dito explicitamente que o objetivo do Exército era a “vingança”, mas expressou que “assim que todos os alvos ligados ao Hamas se tornarem legítimos, e com quase todos os danos colaterais aprovados, ficará claro para vocês que milhares de pessoas vão ser mortas. Mesmo que oficialmente todos os alvos estejam ligados ao Hamas, quando a política é tão permissiva, perde todo o significado.”

A. também usou a palavra “vingança” para descrever a atmosfera dentro do exército depois de 7 de outubro. “Ninguém pensou no que fazer depois, quando a guerra acabar, ou como será possível viver em Gaza e o que eles farão com isso”, disse A.. “Disseram-nos: agora temos que acabar com o Hamas, não importa o custo. Tudo o que você puder, você bombardeia.”

B., a principal fonte de inteligência, disse que, em retrospectiva, acredita que esta política “desproporcional” de matar palestinos em Gaza também põe em perigo os israelenses, e que esta foi uma das razões pelas quais decidiu ser entrevistado.

“No curto prazo, estamos mais seguros, porque prejudicamos o Hamas. Mas acho que estamos menos seguros no longo prazo. Vejo como todas as famílias enlutadas em Gaza – que são quase todas – aumentarão a motivação para [as pessoas se juntarem] ao Hamas daqui a 10 anos. E será muito mais fácil para [o Hamas] recrutá-los.”

Em uma declaração à +972 e Local Call, o Exército israelense negou muito do que as fontes nos disseram, alegando que “cada alvo é examinado individualmente, enquanto é feita uma avaliação individual da vantagem militar e dos danos colaterais esperados do ataque… As IDF não realizam ataques quando os danos colaterais esperados do ataque são excessivos em relação à vantagem militar.”

Passo 5: calcular os danos colaterais

“O modelo não estava conectado com a realidade”

De acordo com fontes de inteligência, o cálculo do Exército israelense do número de civis que se espera serem mortos em cada casa ao lado de um alvo – um procedimento examinado numa investigação anterior pela +972 e Local Call – foi realizado com a ajuda de ferramentas automáticas e imprecisas. Nas guerras anteriores, o pessoal dos serviços de informação passava muito tempo verificando quantas pessoas estavam em uma casa que estava prestes a ser bombardeada, com o número de civis suscetíveis de serem mortos listados como parte de um “arquivo de alvos”. Depois de 7 de outubro, contudo, essa verificação minuciosa foi largamente abandonada em favor da automatização.

Em outubro, o The New York Times noticiou um sistema operado a partir de uma base especial no sul de Israel, que coleta informações de celulares na Faixa de Gaza e fornece aos militares uma estimativa em tempo real do número de palestinos que fugiram do norte da Faixa de Gaza em direção ao sul. O brigadeiro-general Udi Ben Muha disse ao Times que “não é um sistema 100% perfeito – mas fornece as informações necessárias para tomar uma decisão”. O sistema funciona de acordo com cores: vermelho marca áreas onde há muitas pessoas, e verde e amarelo marcam áreas que foram relativamente livres de moradores.

As fontes que falaram com a +972 e Local Call descreveram um sistema semelhante para calcular danos colaterais, que foi usado para decidir se bombardearia um edifício em Gaza. Disseram que o software calculou o número de civis que residiam em cada casa antes da guerra – avaliando o tamanho do edifício e revendo sua lista de residentes – e depois reduziu esses números pela proporção de residentes que supostamente evacuaram o bairro.

Para ilustrar, se o Exército estimasse que metade dos residentes de um bairro tinha saído, o programa contaria uma casa que normalmente tinha 10 residentes como uma casa contendo cinco pessoas. Para poupar tempo, disseram as fontes, o Exército não vigiou as casas para verificar quantas pessoas realmente viviam ali, como fez em operações anteriores, para descobrir se a estimativa do programa era de fato precisa.

“Este modelo não estava ligado à realidade”, afirmou uma fonte. “Não havia qualquer ligação entre aqueles que estavam na casa agora, durante a guerra, e aqueles que estavam listados como vivendo lá antes da guerra. [Em uma ocasião] bombardeamos uma casa sem saber que havia várias famílias lá dentro, escondidas juntas.”

A fonte disse que embora o Exército soubesse que tais erros poderiam ocorrer, esse modelo impreciso foi adotado mesmo assim, por ser mais rápido. Como tal, disse a fonte, “o cálculo dos danos colaterais foi completamente automático e estatístico” – produzindo mesmo números que não eram números inteiros.

Passo 6: bombardear casas de família

“Você matou uma família sem motivo”

As fontes que falaram com a +972 e Local Call explicaram que às vezes havia uma lacuna substancial entre o momento em que sistemas de rastreamento como Where’s daddy? alertou um oficial de que um alvo havia entrado em sua casa e o próprio bombardeio – levando à morte de famílias inteiras, mesmo sem atingir o alvo do Exército. “Aconteceu muitas vezes que atacamos uma casa, mas a pessoa nem estava em casa”, disse uma fonte. “O resultado é que você matou uma família sem motivo.”

Três fontes de inteligência disseram à +972 e Local Call que testemunharam um incidente em que o Exército israelense bombardeou a casa particular de uma família, e mais tarde descobriu-se que o alvo pretendido do assassinato nem estava dentro da casa, uma vez que nenhuma verificação adicional foi realizada em tempo real.

“Às vezes [o alvo] estava em casa mais cedo e à noite ele ia dormir em outro lugar, digamos, no subsolo, e você não sabia disso”, disse uma das fontes. “Há momentos em que você verifica novamente a localização, e há momentos em que você apenas diz: ‘Ok, ele esteve em casa nas últimas horas, então você pode simplesmente bombardear’”.

Outra fonte descreveu um incidente semelhante que o afetou e o fez querer ser entrevistado para esta investigação. “Entendemos que o alvo estava em casa às 20h00. No final, a Força Aérea bombardeou a casa às três da manhã. Depois descobrimos [nesse período de tempo] que ele tinha conseguido mudar-se para outra casa com a família. Havia outras duas famílias com crianças no prédio que bombardeamos.”

Nas guerras anteriores em Gaza, após o assassinato de alvos humanos, a inteligência israelense levava a cabo procedimentos de avaliação de danos causados por bombas (BDA) – uma verificação de rotina pós-ataque para ver se o comandante superior foi morto e quantos civis foram mortos juntamente com ele. Conforme revelado em uma investigação anterior da +972 e Local Call, isso envolvia ouvir ligações de parentes que perderam seus entes queridos. Na guerra atual, no entanto, pelo menos em relação aos militantes juniores marcados com recurso da IA, fontes dizem que este procedimento foi abolido para poupar tempo. As fontes disseram que não sabiam quantos civis foram realmente mortos em cada ataque, e para os supostos agentes de baixo escalão do Hamas e da PIJ marcados pela IA, nem sequer sabiam se o próprio alvo foi morto.

“Você não sabe exatamente quantos matou e quem matou”, disse uma fonte de inteligência à Local Call para uma investigação anterior publicada em janeiro. “Somente quando se trata de agentes seniores do Hamas é que se segue o procedimento BDA. No resto dos casos, você não se importa. Você recebe um relatório da Força Aérea sobre se o prédio foi explodido e pronto. Você não tem ideia de quanto dano colateral houve; você passa imediatamente para o próximo alvo. A ênfase era criar tantos alvos quanto possível, o mais rápido possível.”

Mas embora os militares israelenses possam avançar após cada ataque sem se preocuparem com o número de vítimas, Amjad Al-Sheikh, o residente de Shuja’iya que perdeu 11 membros da sua família no bombardeio de 2 de dezembro, disse que ele e seus vizinhos estão ainda em busca de cadáveres.

“Até agora, há corpos sob os escombros”, disse ele. “Quatorze prédios residenciais foram bombardeados com os moradores dentro. Alguns dos meus parentes e vizinhos ainda estão enterrados.”

Publicado no +972 Magazine.

*Yuval Abraham é jornalista e cineasta radicado em Jerusalém.

Incrível como essa matéria não repercutiu na mídia dita tradicional !!!

Um verdadeiro escândalo !!!

Tanto o caso em si quanto a repercussão !!